1. 节衣缩食-位图 >>> bin(ord('h'))

'0b1101000'

>>> bin(ord('e'))

'0b1100101'

>>> bin(ord('l'))

'0b1101100'

>>> bin(ord('l'))

'0b1101100'

>>> bin(ord('o'))

'0b1101111'127.0.0.1:6379> setbit s 1 1

(integer) 0

127.0.0.1:6379> setbit s 2 1

(integer) 0

127.0.0.1:6379> setbit s 4 1

(integer) 0

127.0.0.1:6379> get s

"h"127.0.0.1:6379> getbit s 4

(integer) 1

127.0.0.1:6379> getbit s 3

(integer) 0127.0.0.1:6379> set w h

OK

127.0.0.1:6379> getbit w 4

(integer) 1

127.0.0.1:6379> getbit w 3

(integer) 0127.0.0.1:6379> set w hello

OK

127.0.0.1:6379> get w

"hello"

127.0.0.1:6379> bitcount w

(integer) 21

127.0.0.1:6379> bitcount w 0 0 # 第一个字符中1的位数

(integer) 3

127.0.0.1:6379> bitcount w 0 1 # 前两个字符中1的位数

(integer) 7

127.0.0.1:6379> bitpos w 0 #第一个0位

(integer) 0

127.0.0.1:6379> bitpos w 1 #第一个1位

(integer) 1

127.0.0.1:6379> bitpos w 1 1 1 #从第二个字符算起,第一个1位

(integer) 9

127.0.0.1:6379> bitpos w 1 2 2 # 从第三个字符算起,第一个1位

(integer) 17127.0.0.1:6379> bitfield w get u4 0 #从第一个位开始取4个位,结果是无符号数(u)

1) (integer) 6

127.0.0.1:6379> bitfield w get u3 2 #从第三个位开始取3个位,结果是无符号数

1) (integer) 5

127.0.0.1:6379> bitfield w get i4 0 #从第一个位开始取4个位,结果是有符号数(i)

1) (integer) 6

127.0.0.1:6379> bitfield w get i3 2 #从第三个位开始取3个位,结果是有符号数(i)

1) (integer) -32. HyperLogLog 1. 使用方法 127.0.0.1:6379> pfadd codehole user1

(integer) 1

127.0.0.1:6379> pfadd codehole user2 user3

(integer) 1

127.0.0.1:6379> pfcount codehole

(integer) 32. pfadd 中的pf 是什么意思 3. pfmerge 合并 127.0.0.1:6379> pfadd codehole2 user4 # 在创建一个

(integer) 1

127.0.0.1:6379> pfmerge codehole codehole2 #将codehole2合并到codehole

OK

127.0.0.1:6379> pfcount codehole

(integer) 4

127.0.0.1:6379> pfcount codehole2

(integer) 1

127.0.0.1:6379> pfadd codehole user4 #重复添加不会计数

(integer) 0

127.0.0.1:6379> pfcount codehole

(integer) 43. 布隆过滤器 1. redis 中的布隆过滤器 docker pull redislabs/rebloom$ docker run -p6379:6379 redislabs/rebloom

1:C 27 Jun 2021 04:12:06.863 # oO0OoO0OoO0Oo Redis is starting oO0OoO0OoO0Oo

1:C 27 Jun 2021 04:12:06.863 # Redis version=6.0.9, bits=64, commit=00000000, modified=0, pid=1, just started

1:C 27 Jun 2021 04:12:06.863 # Configuration loaded

1:M 27 Jun 2021 04:12:06.865 * Running mode=standalone, port=6379.

1:M 27 Jun 2021 04:12:06.865 # WARNING: The TCP backlog setting of 511 cannot be enforced because /proc/sys/net/core/somaxconn is set to the lower value of 128.

1:M 27 Jun 2021 04:12:06.866 # Server initialized

1:M 27 Jun 2021 04:12:06.866 # WARNING overcommit_memory is set to 0! Background save may fail under low memory condition. To fix this issue add 'vm.overcommit_memory = 1' to /etc/sysctl.conf and then reboot or run the command 'sysctl vm.overcommit_memory=1' for this to take effect.

1:M 27 Jun 2021 04:12:06.866 # WARNING you have Transparent Huge Pages (THP) support enabled in your kernel. This will create latency and memory usage issues with Redis. To fix this issue run the command 'echo madvise > /sys/kernel/mm/transparent_hugepage/enabled' as root, and add it to your /etc/rc.local in order to retain the setting after a reboot. Redis must be restarted after THP is disabled (set to 'madvise' or 'never').

1:M 27 Jun 2021 04:12:06.867 * Module 'bf' loaded from /usr/lib/redis/modules/redisbloom.so

1:M 27 Jun 2021 04:12:06.867 * Ready to accept connectionsdocker exec -it 57 bashroot@5734e47e2acb:/data# redis-cli

127.0.0.1:6379> bf.add codehole user1

(integer) 1

127.0.0.1:6379> bf.add codehole user2

(integer) 1

127.0.0.1:6379> bf.add codehole user3

(integer) 1

127.0.0.1:6379> bf.exists codehele user1

(integer) 0

127.0.0.1:6379> bf.exists codehole user1

(integer) 1

127.0.0.1:6379> bf.madd codehole user4 user5 user6

1) (integer) 1

2) (integer) 1

3) (integer) 1

127.0.0.1:6379> bf.mexists codehole user4 user5 user6 user7

1) (integer) 1

2) (integer) 1

3) (integer) 1

4) (integer) 0127.0.0.1:6379> bf.info codehole # 查看布隆过滤器信息

1) Capacity

2) (integer) 100

3) Size

4) (integer) 296

5) Number of filters

6) (integer) 1

7) Number of items inserted

8) (integer) 6

9) Expansion rate

10) (integer) 2

127.0.0.1:6379> bf.debug codehole # 查看布隆过滤器的内部详细信息

1) "size:6"

2) "bytes:144 bits:1152 hashes:8 hashwidth:64 capacity:100 size:6 ratio:0.005"127.0.0.1:6379> bf.reserve codehole2 0.08 500

OK

127.0.0.1:6379> bf.add codehole2 user0

(integer) 1

127.0.0.1:6379> bf.info codehole2

1) Capacity

2) (integer) 500

3) Size

4) (integer) 576

5) Number of filters

6) (integer) 1

7) Number of items inserted

8) (integer) 1

9) Expansion rate

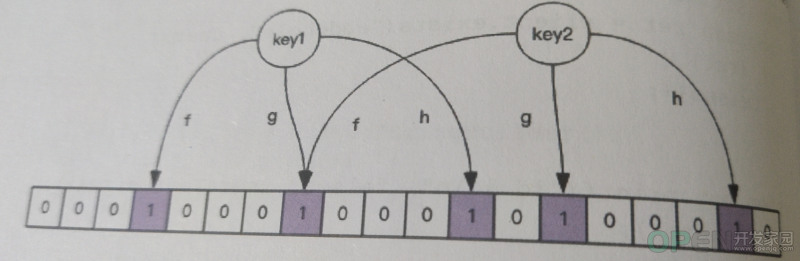

10) (integer) 22. 布隆过滤器基本原理 3. 使用场景 4. GeoHash 1. 基本用法 127.0.0.1:6379> geoadd company 116.48105 39.996794 juejin

(integer) 1

127.0.0.1:6379> geoadd company 116.514203 39.905409 ireader

(integer) 1

127.0.0.1:6379> geoadd company 116.489033 40.007669 meituan

(integer) 1

127.0.0.1:6379> geoadd company 116.562108 39.787602 jd 116.334255 40.027400 xiaomi

(integer) 2127.0.0.1:6379> zrange company 0 -1 WITHSCORES

1) "jd"

2) "4069154033428715"

3) "xiaomi"

4) "4069880904286516"

5) "ireader"

6) "4069886008361398"

7) "juejin"

8) "4069887154388167"

9) "meituan"

10) "4069887179083478"127.0.0.1:6379> geodist company juejin meituan km

"1.3878"

127.0.0.1:6379> geodist company juejin meituan m

"1387.8166"

127.0.0.1:6379> geodist company juejin jd km

"24.2739"

127.0.0.1:6379> geodist company juejin jd m

"24273.9390"127.0.0.1:6379> geopos company jd meituan

1) 1) "116.56210631132125854"

2) "39.78760295130235392"

2) 1) "116.48903220891952515"

2) "40.00766997707732031"

127.0.0.1:6379> geopos company jd

1) 1) "116.56210631132125854"

2) "39.78760295130235392"127.0.0.1:6379> geohash company jd meituan

1) "wx4fk7jgtf0"

2) "wx4gdg0tx40"

127.0.0.1:6379> geohash company jd

1) "wx4fk7jgtf0"# 20 公里以内最多3个元素按距离正排, 它不会排除自身

127.0.0.1:6379> georadiusbymember company ireader 20 km count 3 asc

1) "ireader"

2) "juejin"

3) "meituan"

# 20 公里以内最多3个元素按距离倒排

127.0.0.1:6379> georadiusbymember company ireader 20 km count 3 desc

1) "jd"

2) "meituan"

3) "juejin"

# 三个可选参数,withcoord\withdist\withhash 用来携带附加参数

127.0.0.1:6379> georadiusbymember company ireader 20 km withcoord withdist withhash count 3 asc

1) 1) "ireader"

2) "0.0000"

3) (integer) 4069886008361398

4) 1) "116.5142020583152771"

2) "39.90540918662494363"

2) 1) "juejin"

2) "10.5501"

3) (integer) 4069887154388167

4) 1) "116.48104995489120483"

2) "39.99679348858259686"

3) 1) "meituan"

2) "11.5748"

3) (integer) 4069887179083478

4) 1) "116.48903220891952515"

2) "40.00766997707732031"

# 根据坐标值查询附件的元素

127.0.0.1:6379> georadius company 116.514202 39.905409 20 km withdist count 3 asc

1) 1) "ireader"

2) "0.0000"

2) 1) "juejin"

2) "10.5501"

3) 1) "meituan"

2) "11.5748"2. 原理 【当你用心写完每一篇博客之后,你会发现它比你用代码实现功能更有成就感!】

![]() 数据库

发布于:2021-07-17 13:12

|

阅读数:549

|

评论:0

数据库

发布于:2021-07-17 13:12

|

阅读数:549

|

评论:0

QQ好友和群

QQ好友和群 QQ空间

QQ空间