摘要 Shopee 供应链主要覆盖卖家发货后,仓库拣选商品、交至第三方物流(3rd Party Logistics,下称 3PL)、送达买家过程中的各种场景。Logistics Channel Service 项目(下称 LCS)是物流履约链路上连接内外的一环,收拢了向 3PL 下单、获取物流轨迹更新等对外交互的业务。

从 2019 年 9 月至今,随着上游系统拆分迁移,越来越多 3PL 进入 LCS 负责范围;并且由于电商业务在 2020 年的飞速发展,系统每月的订单量也在陡增,对数据库的要求和压力随之而来,在短短一年内,数据库架构跟随业务增长进行了多次调整。

本文简要回顾了 LCS 诞生至今的数据库架构变化,并介绍项目组在 2020 年底落地的分库实践,梳理落地过程中踩过的坑和总结的经验、教训和思考。

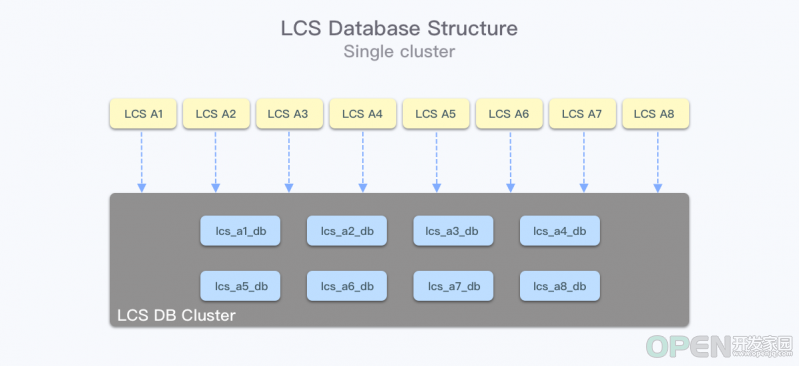

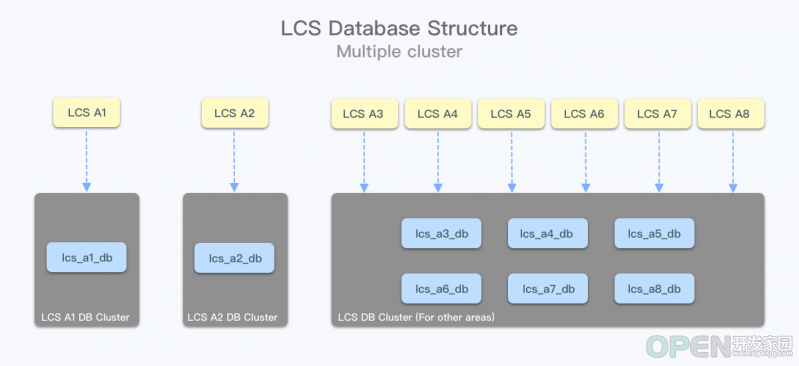

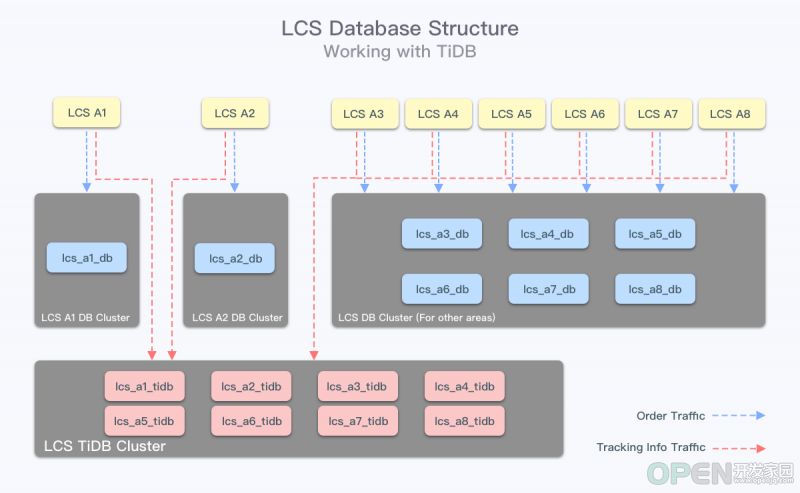

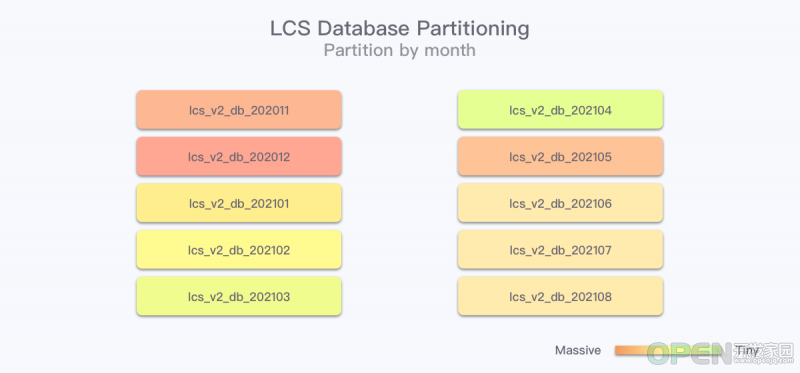

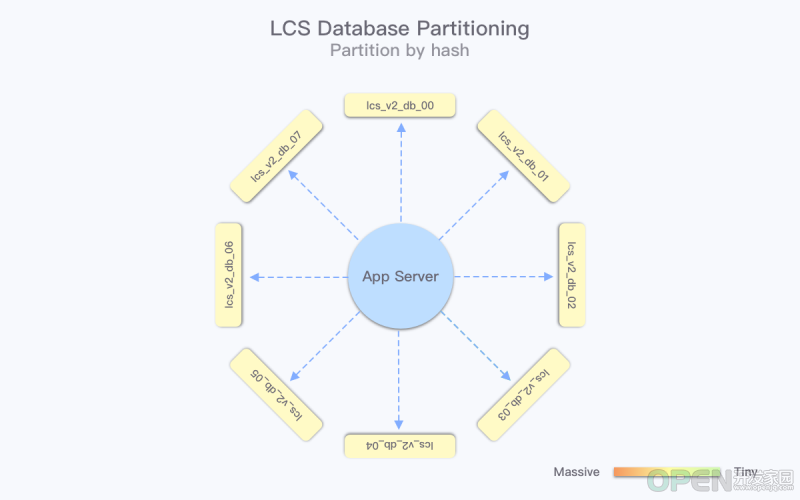

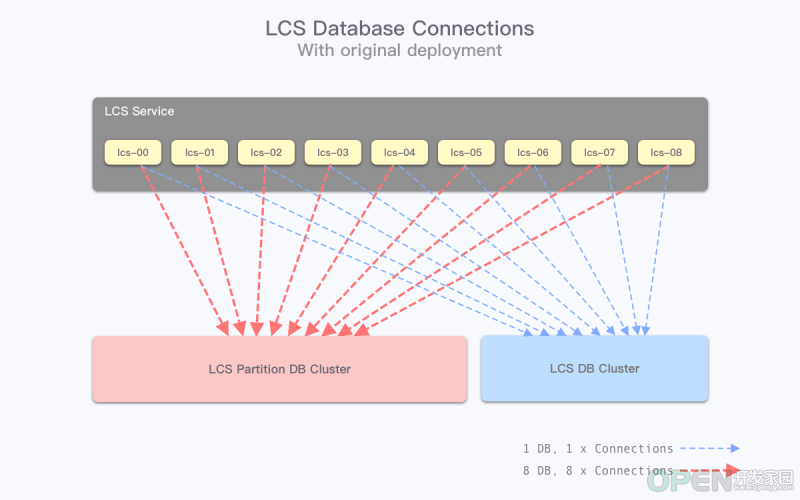

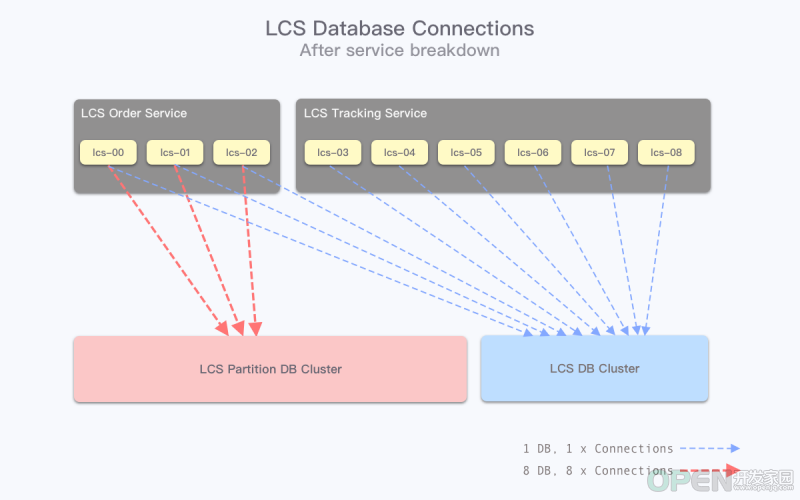

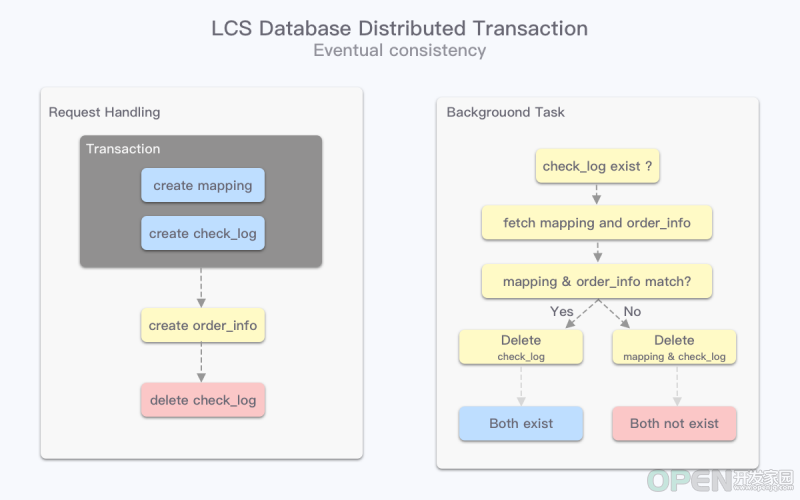

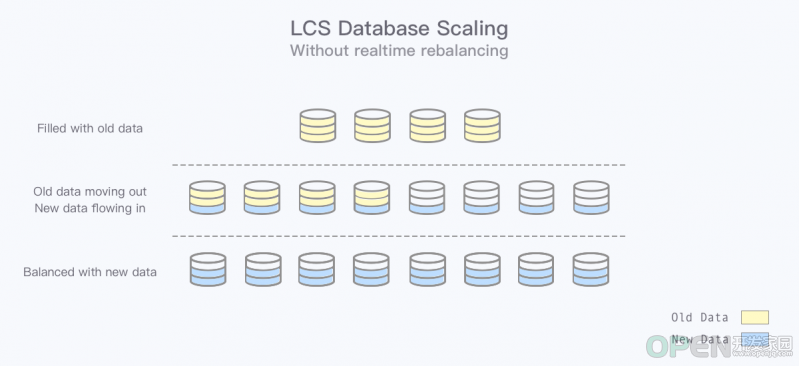

新方案实践的过程中,有遇到常规库表拆分中共有的问题,也有针对项目场景的“特色”问题,解决它们没有十全十美的方案,而更多是权衡取舍的过程,需要结合业务特性来分析和选择最有利的方式处理。1. 背景 1.1 项目起源 订单量大的地区的数据库读写影响了订单量少的地区的 I/O 资源; 轨迹推送 QPS 远比下单高,大量的轨迹信息读写影响了核心的下单流程。 在尽量不影响业务的情况下,我们先选择了将热点地区的数据库拆分到单独的物理集群上,独占资源,保证自身服务稳定的同时,也减少了对其他地区服务的影响。在这个过程中,由于不同市场使用的是不同的逻辑库,所以切换没有任何的业务改动,在 DBA 的协助下,可以非常迅速地完成这个操作。1.2 面临挑战 文本类型数据非常多 ,数据库表的体积 容易暴涨。2. 架构演进 2.1 设计目标 承载未来较长一段时间的数据存储需求 。因为硬件资源有限,很多时候变动并不容易实施,而且重新调整架构也是让 DBA 和业务研发人员非常痛苦的一件事情。 同样稳定可靠 。对核心业务链路上的项目而言,稳定性是最重要的。 保留合理的可扩展性 。重新调整架构很难,但不代表当前架构下不能做业务无感知的横向扩展。 便于进行数据归档 。来自产品团队的需求,数据也是支撑未来业务设计的核心因素。 2.2 方案设计 2.2.1 分库模型 按月份拆分的数据库 。当前的单库设计——所有的数据都落在不同的哈希分表中,要将历史数据捞出来进行转移是非常麻烦的: DBA 团队不会访问和维护数据库中的数据,因此业务侧要自己完成归档操作; 访问和迁移指定时间范围的数据,意味着所有哈希分表的 B+ 树需要发生大量的页合并操作,不利于线上业务的性能。 因此,按月分库的想法初衷是想把可以进行备份归档的数据集中在一起,不管是业务侧想办法迁移,还是 DBA 提供数据库维度的操作,都能简化一定的操作成本。直接按照哈希分库 ,让数据均匀地落到不同的分库中去。但这样又有和单库做数据归档一样的问题——库表均按哈希划分,数据均匀分布,没有较粗的粒度可以定位出历史数据,需要依赖应用层一点一点做迁移。 支撑未来业务 :两种方案都降低了单库的数据量,但是按时间分库会在业务进一步增长后,单库体积继续难以管控;哈希分库会更加均匀。 稳定性 :从部署和使用上,两种方案的稳定性影响因素都比较类似。但是以时间分库可能需要 DBA 团队的手动维护,包括如何持续未来各个月份的数据库等。我们会更倾向于使用人工操作次数少的方案,哈希分库在搭建完成、交付后更可靠。 可扩展性 :按时间分库比较难继续做拆分,例如在未来改成时间+哈希的方案,但是会显著增加复杂度;哈希分库可以考虑直接增加“% base”取余的数值(可能需要迁移数据),业务调整更小、更容易落地。 数据归档 :哈希分库不好处理归档数据,备份迁出操作粒度太细,有应用层的操作开销,引入大量的数据行 DELETE 操作,并且不加以控制资源使用量会影响线上业务;按时间分库如果有 DBA 支持,可以更方便地完成数据归档,操作难度大幅降低。 结合各方面的考量,我们最终选择了哈希分库的方案 ,通过牺牲数据归档操作的便捷性,期望能让业务应用在未来相对更稳定可靠。2.2.2 应用部署架构拆分 单进程连接数 * 进程数 * 机器数 * 数据库数 数据库数是依据业务数据,从保证未来单库数据体积不超过一定值计算得出的,因此不能再继续调低; 进程数和连接池连接数的配置是依照业务请求量调整的,降低的话会让单机的请求处理能力下降。 所以我们尝试在机器数量 上做改变。由于处理下单和处理轨迹推送更新的服务没有分离 ,且轨迹流量是订单流量的数倍 ,因此该服务使用了较多的机器数量同时支撑下单与轨迹更新。但是轨迹流量是暂存 TiDB 而不访问 MySQL 的,如果可以服务分开部署,老服务只负责下单访问 MySQL,新服务轨迹更新只访问 TiDB ,那么需要访问 MySQL 的机器数量就可以大幅降低。根据线上数据统计,轨迹请求数量为下单请求的 9 倍,参考这个比例,并考虑一定冗余机器数保护核心的下单业务流程,我们在 Nginx 代理层将不同类型的接口划分至了不同服务 。机器数量降低到原来的 25% ,相应地,在连接数计算结果上,数值也缩小至 1/4 。应用架构拆分 可能是较为可靠且最容易落地的方案之一 。2.3 业务改造 2.3.1 分库依据与路由规则 新增数据将会在新分库集群上进行读写,而老数据会在原数据库读写 。都依照其中的订单 ID 进行读写 ,毫无疑问订单 ID 可以作为分库的依据 。因为数据库路由由应用层管理,只需要对订单 ID 稍加改造,加入一些标志信息,让应用层能区分开: 订单 ID 应该在原数据库还是新的哈希分库; 订单 ID 应该落在第几个哈希分库。 调整框架内的数据库路由规则比较繁杂,包括将每类表的管理类重写,因为涉及的表比较多,所以也改动了大量的代码,这部分不一一赘述。2.3.2 跨库一致性补偿 与原数据库表的交互就丢失了事务可行性 ,也就是没办法依赖数据库的事务保证它们一致了。MySQL 提供了 XA 跨库强一致事务操作,但是在实际使用中,使用 XA 跨库事务有很大的性能开销,并且也需要开发者有对应的知识储备来正确操作。增加一套检查机制,使得不同库表的操作如果发生异常,也能在异步的检查任务执行完成后,恢复(回退/清理)到一致的状态 。 订单表:在分库中,存有订单 ID 和订单对应 3PL 物流单号信息(通过订单单号获取订单信息,包括 3PL 物流单号); 反查表:在旧库中,存有 3PL 物流单号信息和对应订单单号信息(通过 3PL 物流单号查订单单号)。 由于分库依据是订单 ID ,所以反查表的查询模式(按 3PL 物流单号查询)让它没有办法放在分库中,只有带订单 ID 的查询才能在分库集群上正确被路由,否则需要遍历所有分库获取数据。反查表和订单表就会出现数据不一致的情况 。应用层有定期执行的异步任务 ,通过检查 Checker 信息,对比当前订单表和反查表是否一致 ,如果不一致,则通过修改反查表记录让它们回到一致的状态 。Checker 扮演的角色相当于 InnoDB 中的 undo log ,如果事务执行失败,参照其中的内容进行回退或类似的操作,保证最终一致性。2.4 维护与展望 2.4.1 数据归档 避免集中迁移 ,理论上只要迁移速度等同于下单写入的 QPS 即可维持平衡。因此,根据业务闲忙时段的资源需求,将任务设计按不同的时间间隔周期性执行,对数据库的压力能控制在可接受范围内。2.4.2 无迁移(Rebalance)扩容 增速减缓,归档迁出速度不变 的情况下,原有的 16 个数据库中数据量会逐步从总订单量的 1/16 降低至 1/64,而新增的 48 个数据库数据量也会从 0 增长至 1/64。无法在扩容后马上降低原有数据库的压力 ,因为仍有大量老订单读写落在老数据库中,压力需要随时间缓慢降低 。在监控机制完善且业务增长有一定规律的情况下,我们可以综合这些因素,预留足够多的时间进行扩容、接受缓慢的数据重平衡。2.4.3 未来规划 3. 总结 解决数据持续增长带来的压力 ,放弃粗粒度(库表维度)数据迁移备份能力则是现阶段改造设计时的让步。全年均匀 稳定性/可维护性 依赖人工/定时脚本增加新库 无扩容需求时维护成本低 扩展性 缩小划分间隔,启用更多新库 当前业务场景扩库无需重新平衡数据 数据备份归档 可提供时间粒度的库表迁移 需要遍历具体数据缓慢迁出而在寻求跨库一致性的解决方案上,考虑异常情况出现的比例,并结合业务对不一致数据存在时间的容忍性,我们选择了比 XA 强一致事务更轻量的方案 。定期执行的后台任务让不同库表的数据保持最终一致性,在业务层面易于实现 ,且只需要数据库提供最基础的事务支持,毫无疑问能胜任现有场景要求。本文作者

Jiekun,后端工程师,兴趣方向为 Cache 及 KV 存储,来自 Shopee Supply Chain 团队。本文首发于微信公众号“Shopee技术团队”

![]() 移动开发

发布于:2021-09-01 11:34

|

阅读数:363

|

评论:0

移动开发

发布于:2021-09-01 11:34

|

阅读数:363

|

评论:0

QQ好友和群

QQ好友和群 QQ空间

QQ空间