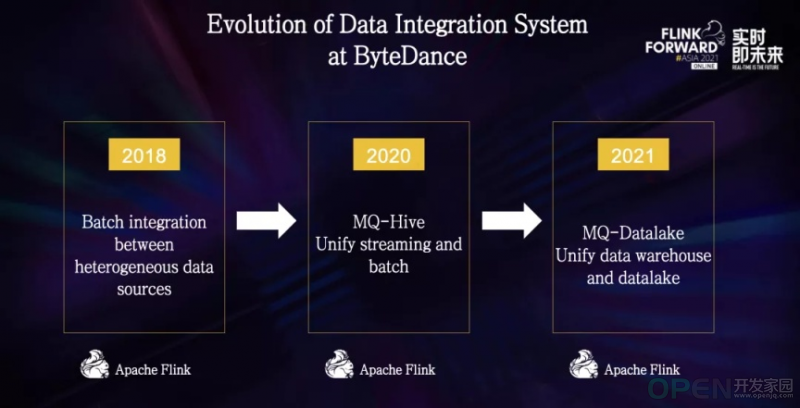

本文是字节跳动数据平台开发套件团队在 Flink Forward Asia 2021: Flink Forward 峰会上的演讲,着重分享了字节跳动数据湖技术上的选型思考和探索实践。

文 | Gary Li 字节跳动数据平台开发套件团队高级研发工程师,数据湖开源项目 Apache Hudi PMC Member字节跳动数据集成的现状

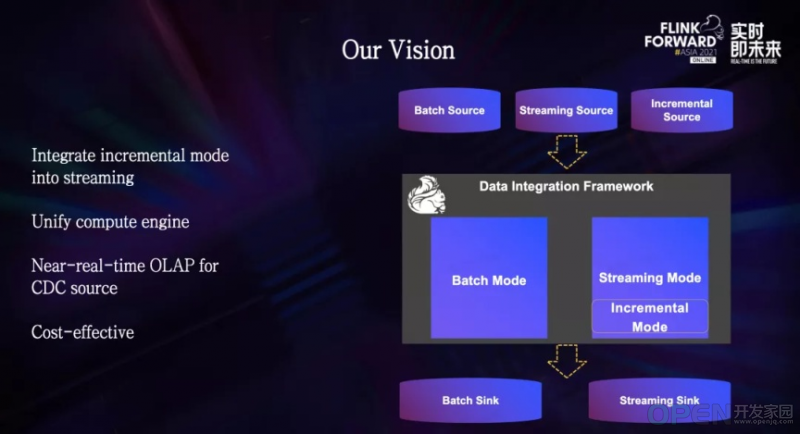

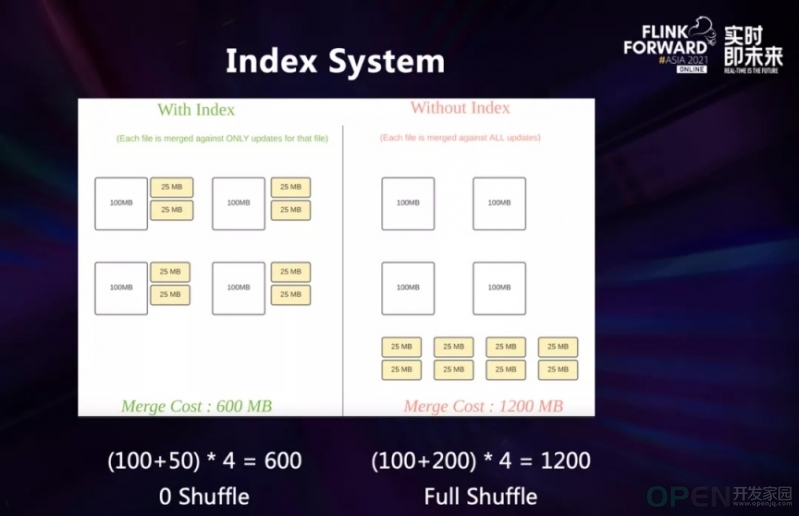

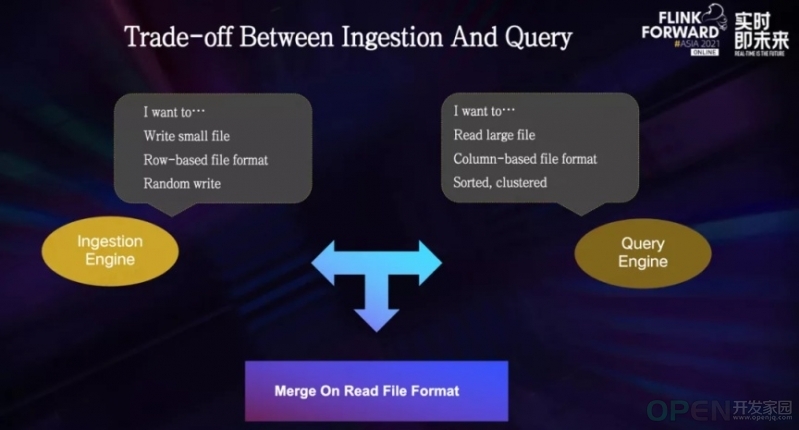

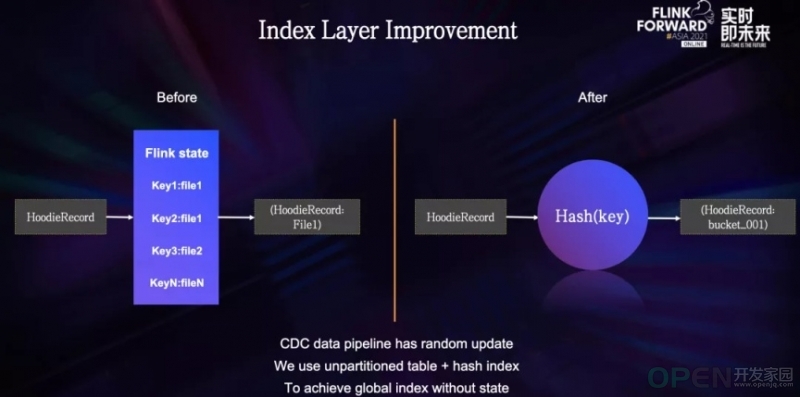

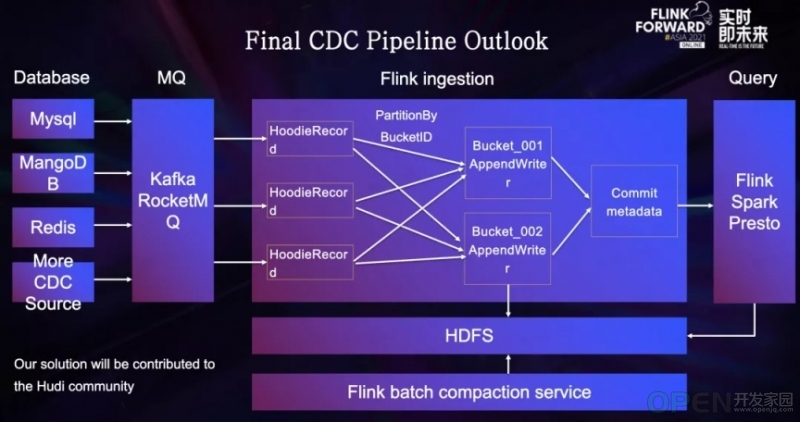

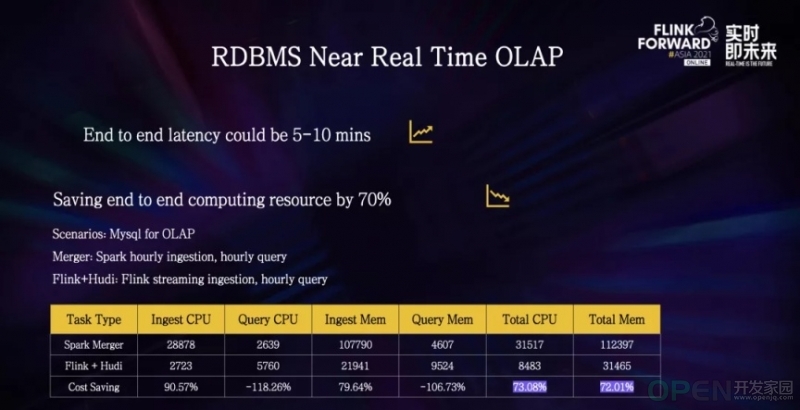

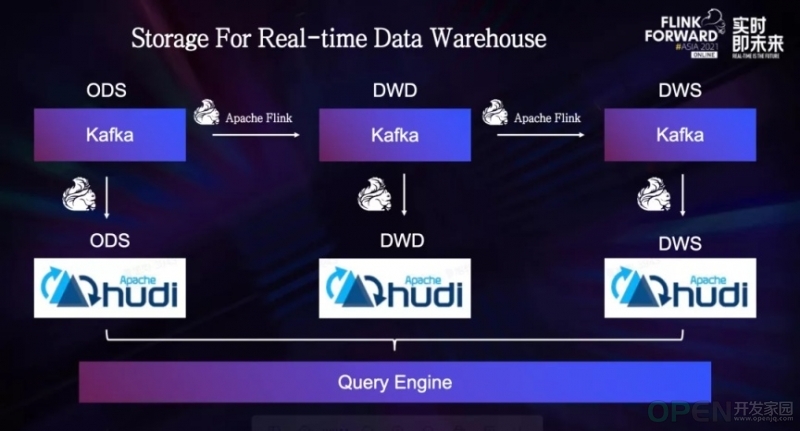

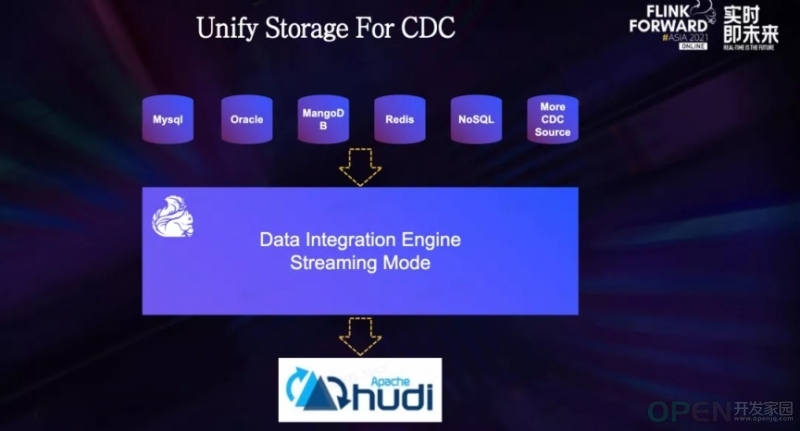

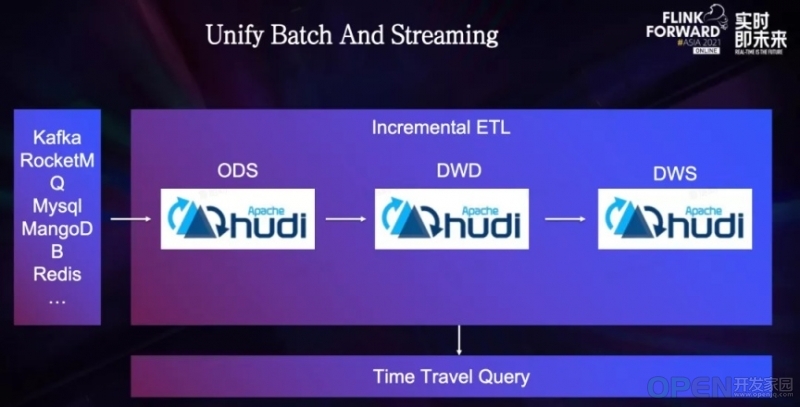

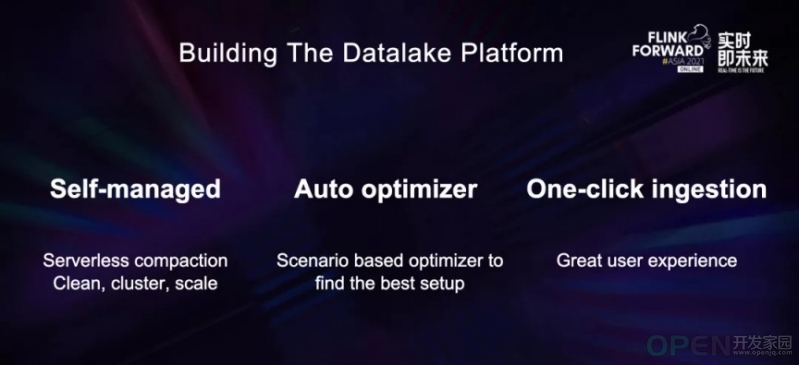

整个系统主要分成 3 种模式——批式集成、流式集成和增量集成。 批式集成模式基于 Flink Batch 模式打造,将数据以批的形式在不同系统中传输,目前支持了 20 多种不同数据源类型。 流式集成模式主要是从 MQ 将数据导入到 Hive 和 HDFS,任务的稳定性和实时性都受到了用户广泛的认可。 增量模式即 CDC 模式,用于支持通过数据库变更日志 Binlog,将数据变更同步到外部组件的数据库。 这种模式目前支持 5 种数据源,虽然数据源不多,但是任务数量非常庞大,其中包含了很多核心链路,例如各个业务线的计费、结算等,对数据准确性要求非常高。关于数据湖技术选型的思考 Iceberg:核心抽象对接新的计算引擎的成本比较低,并且提供先进的查询优化功能和完全的 schema 变更。 Hudi:更注重于高效率的 Upsert 和近实时更新,提供了 Merge On Read 文件格式,以及便于搭建增量 ETL 管道的增量查询功能。 一番对比下来,两个框架各有千秋,并且离我们想象中的数据湖最终形态都有一定距离,于是我们的核心问题便集中在了以下两个问题:01 - 索引系统 1、日志数据去重场景 冷热分区的场景就比较适合布隆索引、带 TTL 的 State 索引和哈希索引。 2、CDC 场景 在这种场景下,我们可以选用哈希索引、State 索引和 Hbase 索引来做到高效率的全局索引。 02 - Merge On Read 表格式 log 文件通常体积较小,包含了新增的更新数据。base 文件体积较大,包含了所有的历史数据。03 - 增量计算 字节跳动内部场景实践思考 需要高效率且低成本的 Upsert

支持高吞吐

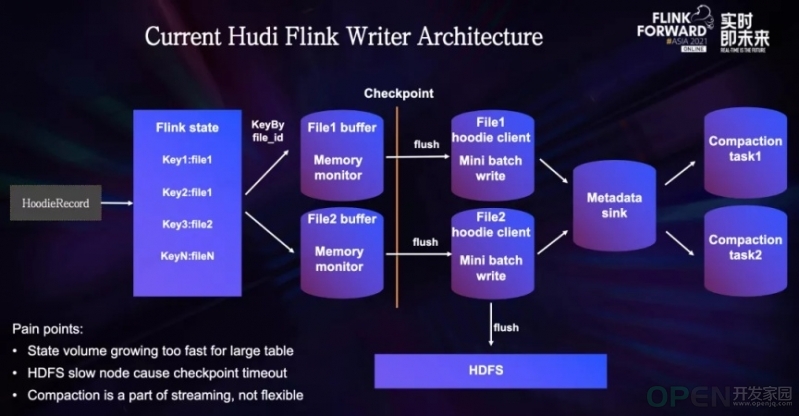

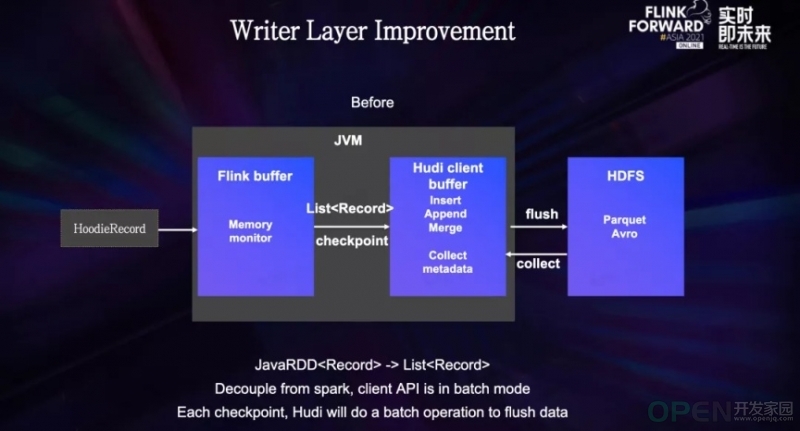

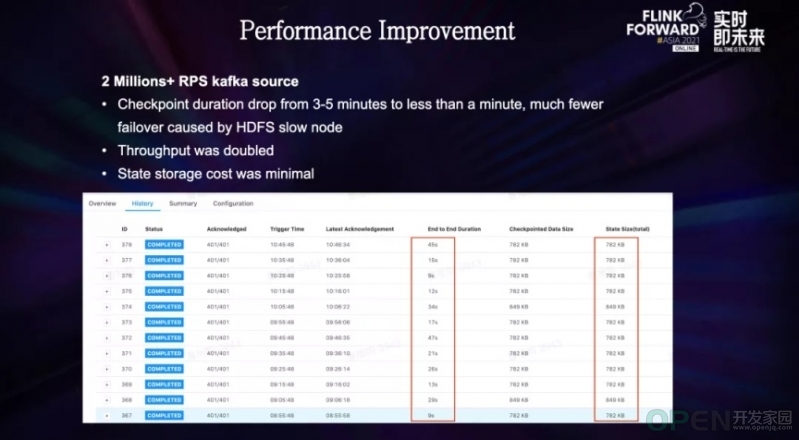

端到端的数据可见性控制在 5-10 分钟以内 State 索引中保存了所有主键和文件 ID 的一一映射关系,对于 Update 数据,会找到其所存在的文件 ID,对于 Insert 数据,索引层会给他指定一个新的文件 ID,或者是历史文件中的小文件,让其填充到小文件中,从而避免小文件问题。 经过索引层之后,每条数据都会带有一个文件 ID,Flink 会根据文件 ID 进行一次 shuffle,将相同文件 ID 的数据导入到同一个子任务中,同时可以避免多个任务写入同一个文件的问题。 写入子任务中有一个内存缓冲区,用于储存当前批次的所有数据,当 Checkpoint 触发时,子任务缓冲区的数据会被传入 Hudi Client 中,Client 会去执行一些微批模式的计算操作,比如 Insert/Upsert/Insert overwrite 等,每种操作的计算逻辑不同,比如说 Insert 操作,会生成一个新的文件,Upsert 操作可能会和历史文件做一次合并。 待计算完成后,将处理好的数据写入到 HDFS 中,并同时收集元数据。 Compaction 任务为流任务的一部分,会定时的去轮训 Hudi 的时间线,查看是否有 Compaction 计划存在,如果有 Compaction 计划,会通过额外的 Compaction 算子来执行。 在测试过程中,我们遇到了以下几个问题: 在数据量比较大的场景下,所有的主键和文件 ID 的映射关系都会存在 State 中,State 的体积膨胀的非常快,带来了额外的储存开销,并且有时会造成 Checkpoint 超时的问题。 第二个问题是,由于 Checkpoint 期间,Hudi Client 操作比较重,比如说和底层的 base 文件进行合并,这种操作涉及到了历史文件的读取,去重,以及写入新的文件,如果遇到 HDFS 的抖动,很容易出现 Checkpoint 超时的问题 第三个问题是,Compaction 任务作为流式任务的一部分,任务启动后资源就不可调节,如果需要调节,只能重启整个任务,开销比较大,如果不能灵活调节 Compaction 任务,就可能会出现 Compaction 算子空跑导致资源浪费,或者资源不足导致任务失败的情况 为了解决这些问题,我们开始针对我们的场景进行了定制化的优化字节跳动的定制化优化技术方案 01 - 索引层 02 - 写入层 03- Compaction 层 流式数据湖集成框架的典型落地场景 结语 欢迎关注字节跳动数据平台同名公众号

![]() 网络安全

发布于:2022-01-26 11:29

|

阅读数:903

|

评论:0

网络安全

发布于:2022-01-26 11:29

|

阅读数:903

|

评论:0

QQ好友和群

QQ好友和群 QQ空间

QQ空间