关于何为Proguard,可以参考GuardSquare官网其优化业务及Wikipedia相关条目.

Proguard:https://www.guardsquare.com/proguard

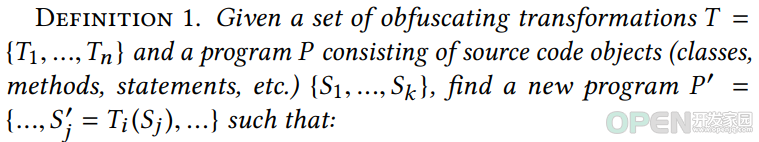

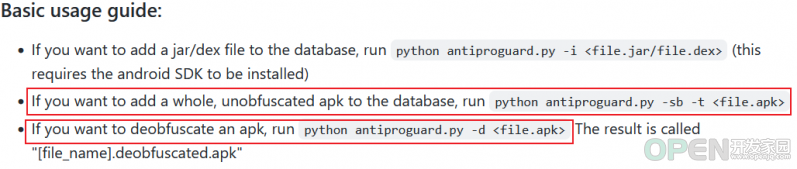

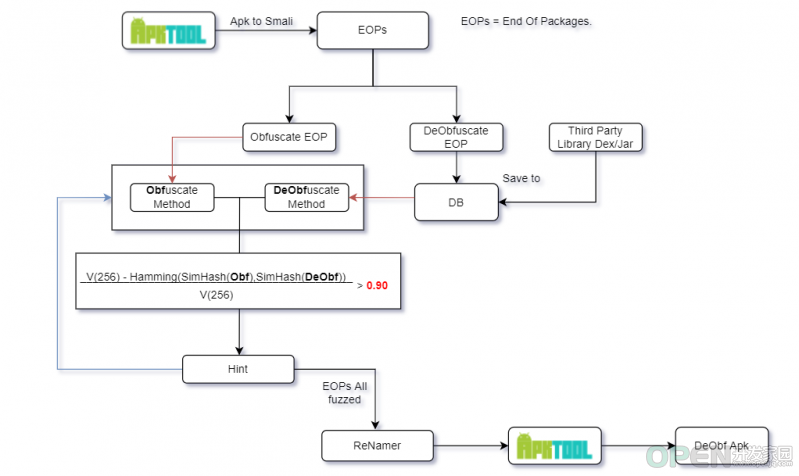

Wikipedia:https://en.wikipedia.org/wiki/ProGuard前言 Richard Baumann 于2017年提出的混淆还原方案,局部敏感哈希与Proguard混淆对抗 Richard Baumann 发表了标题为"Anti-ProGuard: Towards Automated Deobfuscation of Android Apps "(DOI:10.1145/3099012.3099020)的论文,其旨在利用SimHash 算法实现对Apk的自动化反混淆.关于何为SimHash,简要来讲可以理解为可用之计算两个文本片段相似度的算法 ,此处不再进行具体阐述,可以参考Google在2007年发表的论文"Detecting Near-Duplicates for Web Crawling "(DOI:10.1145/1242572.1242592).Obfuscating 的过程是多个Transformation 的集合,论文设欲混淆工程为P ,而P 可看作同时包含多个对象的对象集合,对象集合中包含的对象与未混淆之工程中的类,方法,成员一 一存在映射关系,作者统一称这些对象为S .即P={S1,S2,S3...} P' ,而Proguard的混淆过程可看作一个能够传入任意量的Transformation 函数T(x) ,即P'={T(S1),T(S2),T(S3)...} .可见论文强调整个混淆过程为对整个未混淆工程中各个元素进行转换的总和(事实上也确实如此),而该思想在接下来的分析中也会多次得到体现.Richard Baumann 已经将自动化方案落地,在其Github账户ohaz下即可找到对应的POC项目(论文中并未给出其实现的项目地址,而该项目的首次commit时间最早为2016年,即早于论文发布时间 ).接下来以该项目具体分析自动化反混淆的实现思路.假设一个前提:数据库中已经填充了足够多的未混淆Apk .被混淆 )与数据库中储存的各个 方法实体(未混淆 )分别进行相似度对比,并依据相似度对比结果判断是否生成一个hint,该生成的hint将作为辅助分析其他被混淆方法实体的依据.

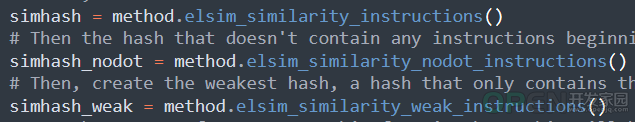

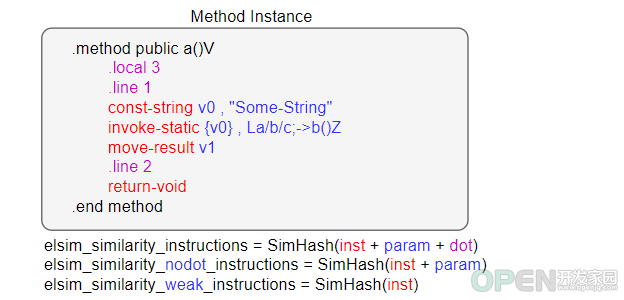

对被混淆方法实体 分别生成了三个不同的SimHash值,而经过后续验证,这三个SimHash的产生均与方法实体所对应的操作码串有高度关联 ,则此三个SimHash值的关系可以下图进行表达.

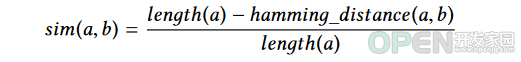

被混淆方法实体 的关联强度有关,并按照关联强度以由大到小的顺序排列.未混淆方法实体 对应产生的此三个SimHash值以论文中提到的如下方式分别进行一次计算:

相似程度 ,接着程序判断计算出的相似程度 是否大于90% ,若超过该值,则判断该被混淆方法实体 与正在与之进行对比的未混淆方法实体 高度相似,此时即可为下一次compare的调用产生一个hint,根据该hint以加快识别其他方法实体相似程度的速度,此处不再对hint更进一步分析.强相关 的关系.

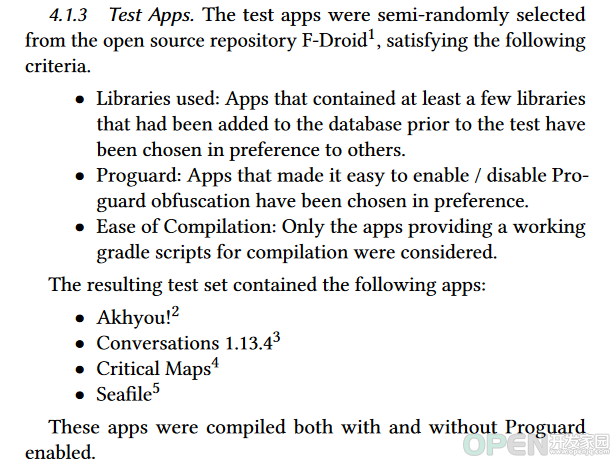

F-Droid 上开放源代码的项目,且这些项目至少使用了一个或多个开源的第三方库 ,这些开源第三方库将在正式测试前被导入至数据库中,以启用Proguard优化的情况下编译项目,以反混淆工具提供的方案处理之,虽然最终该反混淆方案正确还原的包超过了50%,但该方案依然在很大程度上无法胜任真正的逆向工程实战.其一,回顾上文对关键方法compare的分析,不难发现一个需求与方案实现上的冲突,即逆向工程的本质是分析与剥离被分析对象最有价值的核心代码,而根据compare的实现可知其对方法实体的分析基于数据库中数据量的多少,而能够输入数据库的数据也仅限于第三方的开源支持库(你总不能输入一些能够还原未开源代码的数据吧,这形成了悖论 ).

其二,论文第一部分明确指出,其所提出的基于相似性算法的混淆代码还原方案基于数据库中的已知代码 ,而如第一点所言,能输入数据库的代码主要来源于第三方的开源支持库,故该论文提出的所谓通用性方案仅能对本就开源但被混淆的部分 进行还原. 想象一下如今用户能够从已知渠道下载的软件,其臃肿程度导致的代码量可见一斑 ),即使能还原所有第三方开源库代码,对逆向工程的帮助也是微乎其微.DataFlow分析与Proguard混淆对抗 本质都是尝试辅助逆向工程人员'理解'被混淆方法实体,排除无意义短字节的干扰 ,以减少逆向工程中抽离出有价值代码的时间成本.JADX 进行联动,且分析对象由单一的成员拓展至方法,可通过分析欲分析方法中的参数在被标记为污点的情况下的向下传播方向,即DataFlow分析 .

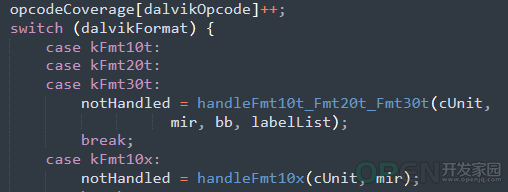

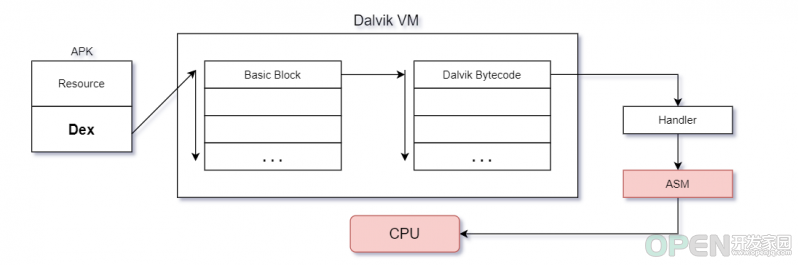

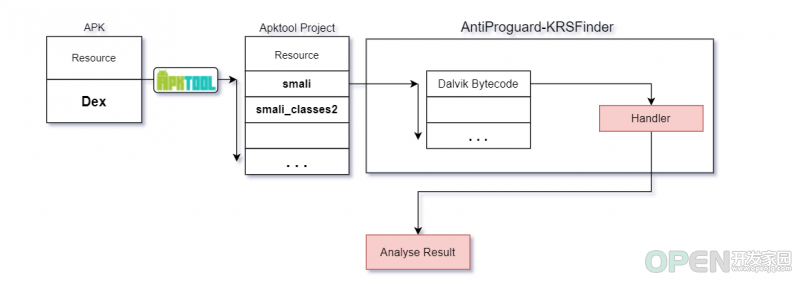

Dalvik操作码 ,为操作码分配相应的句柄以具体处理操作码的操作对象,并依据处理结果进一步分析Apk内各个类的成员与方法,生成对应的分析报告用以联动JADX.(关于Dalvik操作码,可以参考Gabor Paller 于2009年提供的Dalvik Opcodes ).像Dalvik虚拟机一样思考 得其IR ,何如?处理思想 ,固然是要引Google之鉴的.然则自Android5.0开始,Google就弃用Dalvik转而以ART虚拟机处理Dex,但ART绝大情况下使用AOT技术,仅于技术需求而言,该项目对操作码的处理思想必然要取JIT之鉴 ,故该部分将分析Dalvik虚拟机处理字节码的部分实现,进以指导项目实现 .

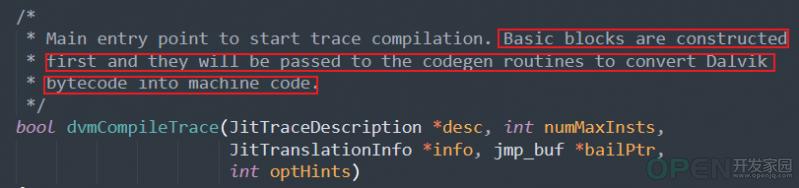

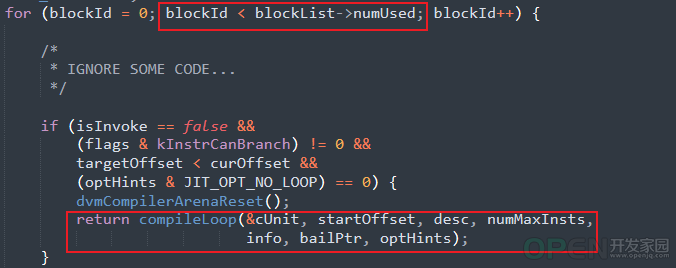

Android-4.0.1_r1 分支下的Dalvik虚拟机源码为例,Dex实例将流入Frontend.cpp文件下dvmCompileTrace函数,该函数正是将Dalvik字节码转换为机器码的入口函数.

dvmCompilerMIR2LIR ,顾名思义,此函数将Dalvik字节指令处理为LIR ,最终由其他方法处理LIR为机器码.

Android4.0 Dalvik虚拟机 处理字节码的大致流程已经分析完毕,如上图流程图所示,该流程及其Dalvik字节码处理思想将被运用到接下来的项目结构中.项目实现 项目已经开源,可至AntiProguard-KRSFinder下查看项目具体代码.

基于前文对Dalvik虚拟机处理字节码的流程分析,基于Dalvik思想绘制如上流程图,该图所示流程在项目正式开始前被作为

理想流程框架 用以指导项目进行,并且在已经完成的项目中其对字节码的大致处理流程也接近该理想流程框架.

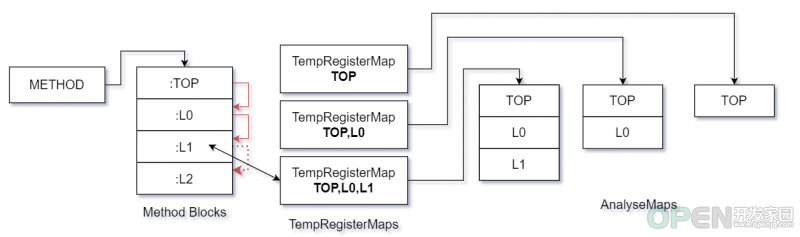

由Dalvik虚拟机源码下docs文件夹中文档的部分描述可知Dalvik虚拟机是

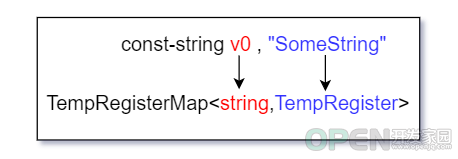

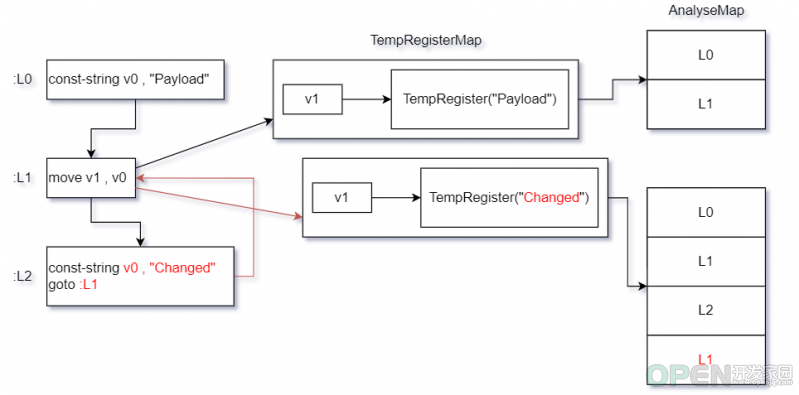

基于寄存器 的.故项目也需要一个组件用以储存寄存器,该组件即为项目中TempRegisterMap.cs文件下的TempRegisterMap类.而该组件本质上是一个Dictionary对象,该组件其键为Dalvik操作码具体操作的

寄存器其名 (即p0,v0...),其值为TempRegister对象,该对象即代表一个具体的寄存器,此寄存器

目前仅需要储存字符串与方法 .下图为该组件大致结构.

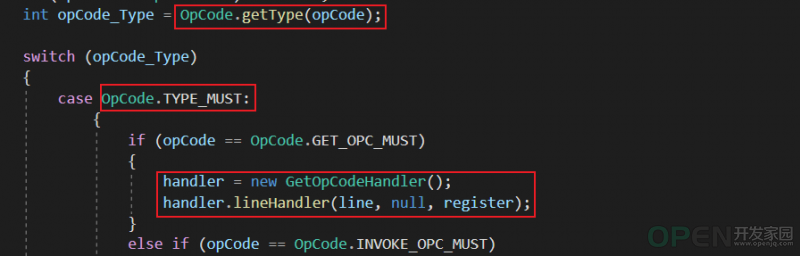

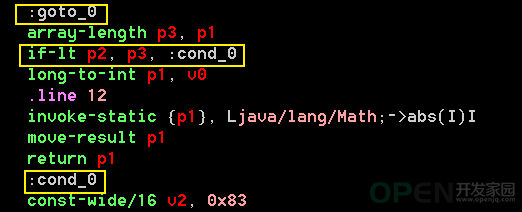

methodAnalyse 函数,该函数为项目处理操作码的正式入口,可以看到该部分我效仿Dalvik虚拟机处理单个字节码的流程模式,为即将处理的操作码分类,并为之分配处理句柄以具体解析操作码及其携带的寄存器,值得一提的是该函数的实现并不完全 与Dalvik虚拟机处理操作码的形式相同,在正式为操作码分配处理句柄前,我将操作码的处理优先级以 MUST,CHECK,PASS 划分,被赋予MUST优先级的操作码将被优先分配处理句柄,赋予CHECK优先级的操作码将在检查其具体操作的寄存器是否有必要处理 后再为操作码分配处理句柄,赋予PASS优先级的操作码将不进行任何解析,以此略去部分不必要解析的操作码,以加快整个流程的处理速度.方法区块 (以下称为块 )的含义.块 ,即以多个块组成一个函数,欲简单理解块 ,可以ASM 中的JMP 指令为参考,JMP指令可以跳跃到内存中的任意地址,而在Dalvik中则以块 为跳跃对象,即在Dalvik中以块 为基本单位组成执行流程.以市面上常见的工具抽离Dex其操作码串,输出的结果中大多以高级语言中Label 的形式表示函数中的块,如下图为带有多个块的函数片段.

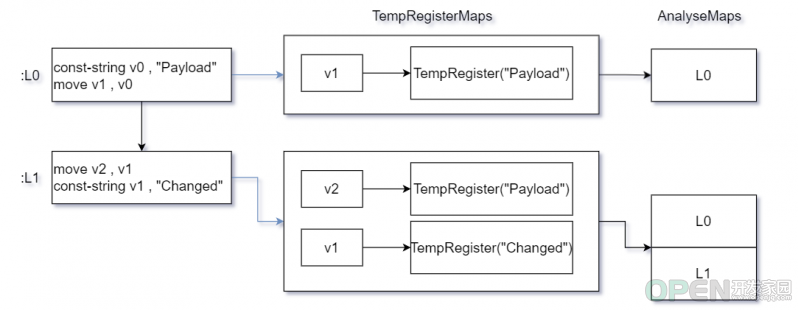

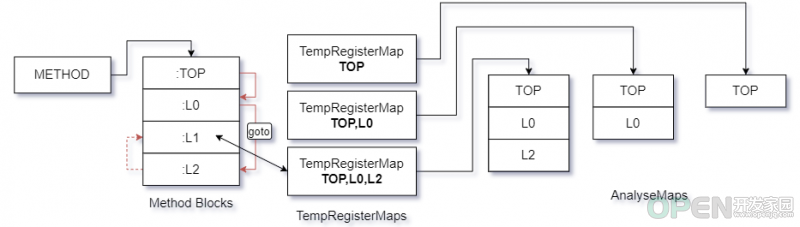

块 ,而上图所示流程即为项目在该情况下的大致处理流程,假设一个理想情况 ,此时块与块之间没有任何指令使得程序跨块跳跃,即执行流程从块顶部向下执行直到方法结束,那么项目将在每个块执行结束时,立刻截取当前块的寄存器集(即TempRegisterMap组件)快照,并且记录当前的执行路线,以寄存器集快照为引索保存每次执行路线,那么在该执行流程下,寄存器集将以如下图情况保存.

if,goto ).若流程控制指令为 goto 指令,项目将标记其操作对象为强行跳转目标 ,并继续向下执行,但不具体解析非强行跳转目标的块,直到目标块被找到 才具体对块中操作码进行解析. 若为 if 类指令,项目将仅对其操作对象进行标记,而不令项目强行寻找目标块 ,正常向下执行并解析 块.

![]() 移动开发

发布于:2022-06-01 17:01

|

阅读数:505

|

评论:0

移动开发

发布于:2022-06-01 17:01

|

阅读数:505

|

评论:0

QQ好友和群

QQ好友和群 QQ空间

QQ空间