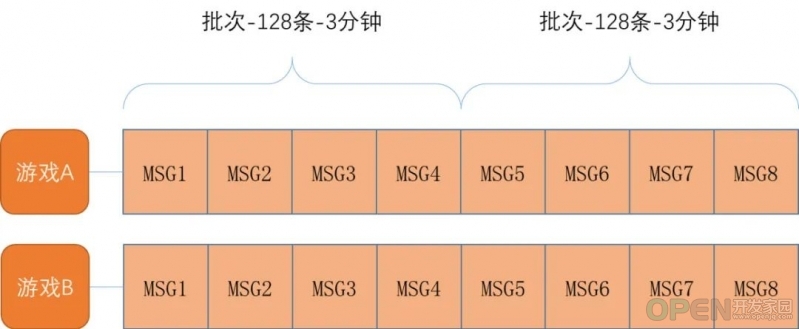

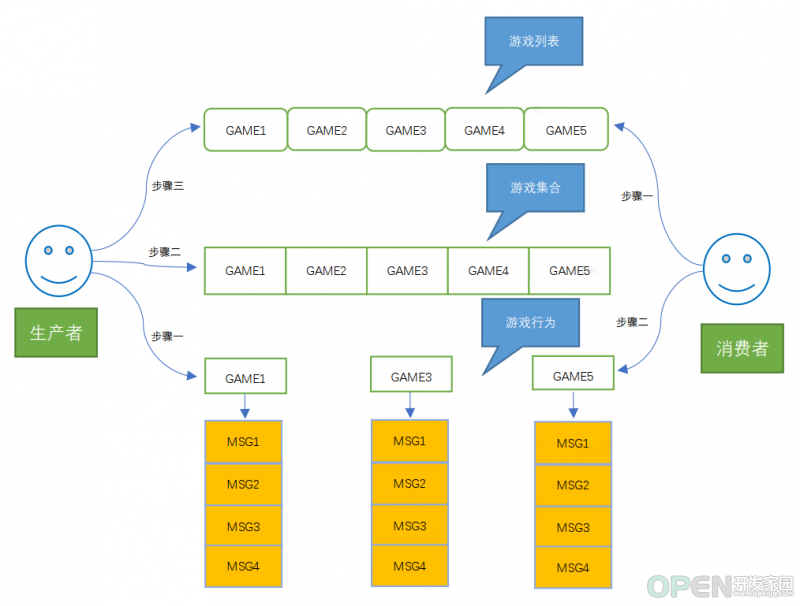

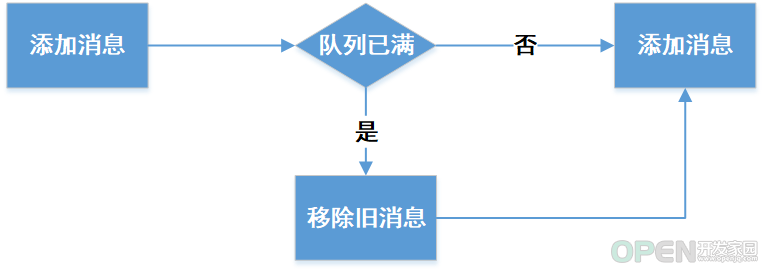

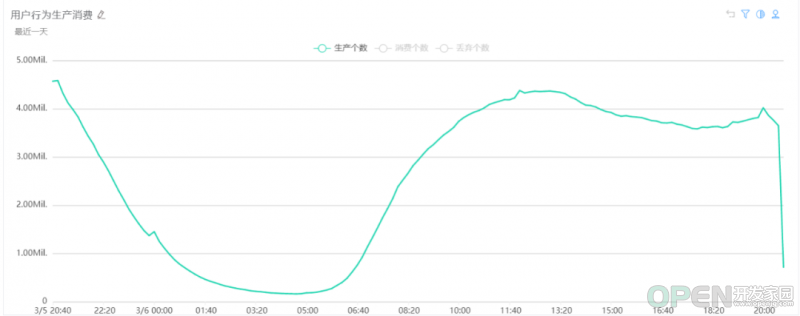

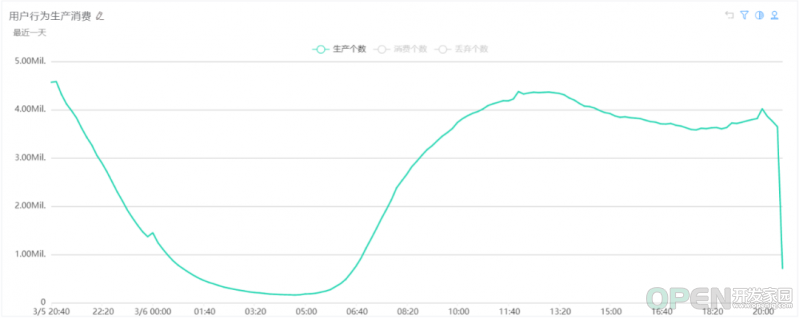

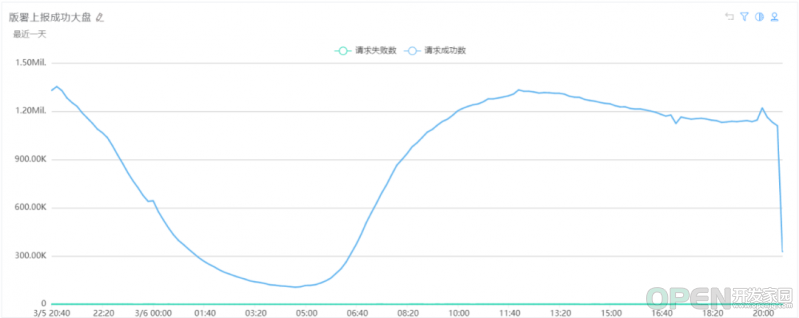

vivo 互联网服务器团队 - Wang Zhi游戏维度的批量行为上报,行为上报的时效限制,细化到各个技术方案选型进行对比。 方案一 没有解决任何业务场景中提及的游戏维度拆分、批量性和时效性。 方案二 消息分组、批量消费 、时效性 。通过Redis的list结构来实现队列(进一步要求实现定长队列)来解决游戏维度的消息分组;通过Redis的list支持的Lrange来实现批量消费;通过业务侧的多线程来解决时效问题,针对高频的游戏使用单独的线程池进行处理,上述两个手段能够保证消费速度大于生产速度。方案对比 通过List对象实现定长队列来保存游戏维度的行为消息(以游戏作为key的List对象来保存用户行为); 通过List来保存所有的存在行为数据的游戏列表; 通过Set来进行去重判断来保证2中的List对象的唯一性。 生产过程 步骤一: 游戏维度的某行为数据PUSH到游戏维度的队列当中。步骤二: 判断游戏是否在游戏的集合Set中,如果在就直接返回,如果不在进行步骤三。步骤三: 往游戏列表中PUSH游戏。消费过程 步骤一: 从游戏对象的列表中循环取出一款游戏。步骤二: 通过步骤一获取的游戏对象去该游戏对象的行为数据队列中批量获取数据处理。EVAL script numkeys key [key ...] arg [arg ...] 时间复杂度:取决于脚本本身的执行的时间复杂度。 > eval "return {KEYS[1],KEYS[2],ARGV[1],ARGV[2]}" 2 key1 key2 first second1) "key1"2) "key2"3) "first"4) "second" Redis uses the same Lua interpreter to run all the commands.Also Redis guarantees that a script is executed in an atomic way:no other script or Redis command will be executed while a script is being executed.This semantic is similar to the one of MULTI / EXEC.From the point of view of all the other clients the effects of a script are either still not visible or already completed. Lua 脚本内多个命令以原子性的方式执行,保证了命令执行的线程安全。 Lua 脚本结合List命令实现定长队列,实现批量消费。 Lua 脚本仅支持单个key的操作,不支持多key的操作。 LLEN key 计算List的长度 时间复杂度:O(1)。 LPOP key [count] 从List的左侧移除元素 时间复杂度:O(N),N为移除元素的个数。 RPUSH key element [element ...] 从List的右侧保存元素 时间复杂度:O(N),N为保存元素的个数。 List的基础命令包括计算List的长度,移除数据,添加数据,整体命令的复杂度都在O(N)的常量时间。 整合上述三个命令,我们能保证实现固定长度的队列,通过判断队列长度是否达到定长结合新增队列元素和移除队列元素来完成。 LRANGE key start end 时间复杂度:O(S+N), S为偏移量start, N为指定区间内元素的数量。 下标(index)参数 start 和 stop 都以 0 为底,也就是说,以 0 表示列表的第一个元素,以 1 表示列表的第二个元素,以此类推。 你也可以使用负数下标,以 -1 表示列表的最后一个元素, -2 表示列表的倒数第二个元素,以此类推。 LTRIM key start stop 时间复杂度:O(N) where N is the number of elements to be removed by the operation. 修剪(trim)一个已存在的 list,这样 list 就会只包含指定范围的指定元素。 List的基础命令包括批量返回数据和裁剪数据,整体命令的复杂度都在O(N)的常量时间。 整合上述两个命令,我们能够批量消费数据并移除队列数据,通过LRANGE批量返回数据并通过LTRIM保留剩余数据。 SADD key member [member ...] 往Set集合添加数据。 时间复杂度:O(1)。 SISMEMBER key member 判断Set集合是否存在元素。 时间复杂度:O(1)。 通过Set集合来保证数据的唯一性,且时间复杂度可控。 定义LUA脚本 CACHE_NPPA_EVENT_LUA = "local retVal = 0 " + "local key = KEYS[1] " + "local num = tonumber(ARGV[1]) " + "local val = ARGV[2] " + "local expire = tonumber(ARGV[3]) " + "if (redis.call('llen', key) < num) then redis.call('rpush', key, val) " + "else redis.call('lpop', key) redis.call('rpush', key, val) retVal = 1 end " + "redis.call('expire', key, expire) return retVal"; 执行LUA脚本 String data = JSON.toJSONString(nppaBehavior); Long retVal = (Long)jedisClusterTemplate.eval(CACHE_NPPA_EVENT_LUA, 1, NPPA_PREFIX + nppaBehavior.getGamePackage(), String.valueOf(MAX_GAME_EVENT_PER_GAME), data, String.valueOf(NPPA_TTL_MINUTE * 60)); 执行效果 实现固长队列的数据存储并设置过期时间 通过整合llen+rpush+lpop三个命令实现定长队列。 通过lua脚本保证上述命令的原子性执行。

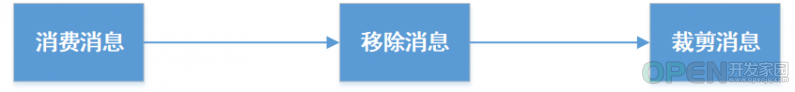

整体的执行流程如上图所示,核心理念通过lua脚本的原子性保证了队列长度计算(llen)、队列数据移除(lpop)、队列数据保存(rpush)的原子性执行。 定义LUA脚本 QUERY_NPPA_EVENT_LUA = "local data = {} " + "local key = KEYS[1] " + "local num = tonumber(ARGV[1]) " + "data = redis.call('lrange', key, 0, num) redis.call('ltrim', key, num+1, -1) return data"; 执行LUA脚本 Integer batchSize = NppaConfigUtils.getInteger("nppa.report.batch.size", 1); Object result = jedisClusterTemplate.eval(QUERY_NPPA_EVENT_LUA, 1,NPPA_PREFIX + gamePackage, String.valueOf(batchSize)); 执行效果 取固定数量的对象,然后保留队列的剩余的消息对象。 通过整合lrange+ltrim两个命令实现消息的批量消费。 通过lua脚本保证上述命令的原子性执行。

整体的执行流程如上图所示,核心理念通过lua脚本的原子性保证了数据获取(Lrange)和数据裁剪(Ltrim)的原子性执行。 整体的消费流程选择pull模式,通过多线程循环轮询可消费的队列进行消费。与借助于redis的pub/sub的通知机制实现消费流程的push模式相比,pull模式成本更低效果更佳。 Redis集群模式下,执行Lua脚本建议传单key,多key会报重定向错误。 在不同的Redis版本下,Lua脚本针对null的返回值处理不同,参考官方文档。 消费者的消费过程中通过循环遍历游戏列表,然后根据游戏去获取对应的消息对象,但是不同的游戏对应的热度不同,所以在消费端我们通过配置的方式为热门游戏单独开启消费线程进行消费,相当于针对不同游戏配置不同优先级的消费者。

生产和消费的QPS约为1w qps左右,整体上报QPS通过批量上报后会远低于生产的消息生产和消费的QPS。 整体数据的使用游戏包名作为key进行存储,性能上不存在热点的问题。 消息的单个生产批量消费 的场景,通过多key形式实现消息队列的多Topic模式,重要的是能够借助于redis的原生能力在O(N)的时间复杂度完成批量消费。另外该方案也可以降级作为实现先进先出定长的日志队列。猜你喜欢 Redis 内存优化在 vivo 的探索与实践 Redis 在 vivo 推送平台的应用与优化实践 本文分享自微信公众号 - vivo互联网技术(vivoVMIC)。

![]() 网络安全

发布于:2022-08-09 10:00

|

阅读数:427

|

评论:0

网络安全

发布于:2022-08-09 10:00

|

阅读数:427

|

评论:0

QQ好友和群

QQ好友和群 QQ空间

QQ空间