本章的内容是对自然语言的分析,并非单纯数与字符的统计,而是尝试去理解人类的语言描述概念。自然语言通常是指一种自然地随文化演化的语言。例如,汉语、英语、日语为自然语言的例子,这一种用法可见于自然语言处理一词中。

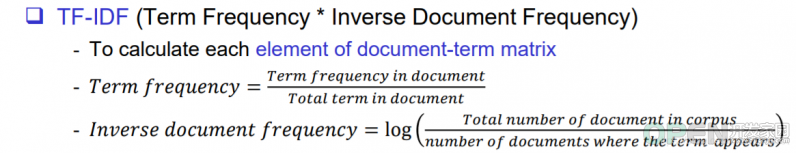

TF-IDF (Term Frequency * Inverse Document Frequency)

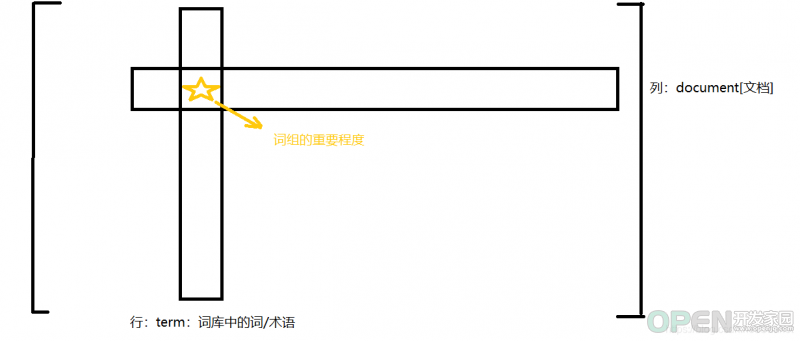

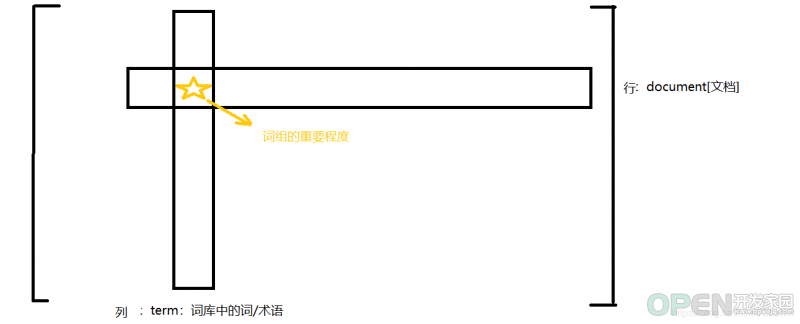

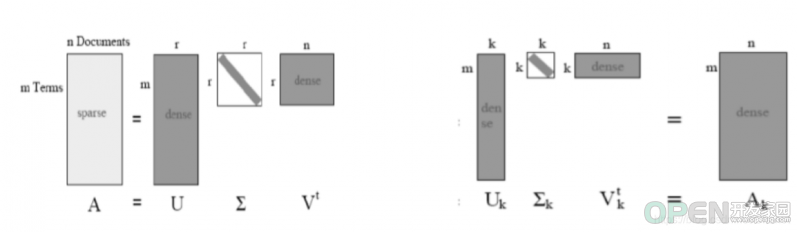

LSA算法将表格变化成矩阵,其行为文档n,列为词库中的词。通过上述式子来计算他们各自的值,我们来一一讨论一下这个公式。

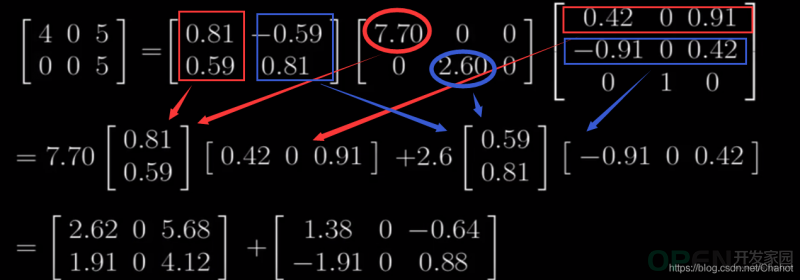

那么,理解了上面两个因式以后,为什么要用log函数呢? TF-IDF 的弊端:否定是一个很重要的语义成分,但是如果把所有的否定词单独拿出,并进行统计,那么否定的低频率注定被忽视,此后得出的分析结果往往不尽人意 忽略了句子结构和顺序。在某些倒装句,修辞语法中表达的潜在含义会随着词语拆分和词语统计变成单纯的线性单词统计。也会对分析的结果造成影响 一词多义。可能会有一个词具有多种意思的情况。比如band有乐队和波段和带状物的意思,“Radiohead is the best band ever” and “I broke a rubber band”中两个band不是同一个意思,但是他会被统计为同一个词语。 SVD分解

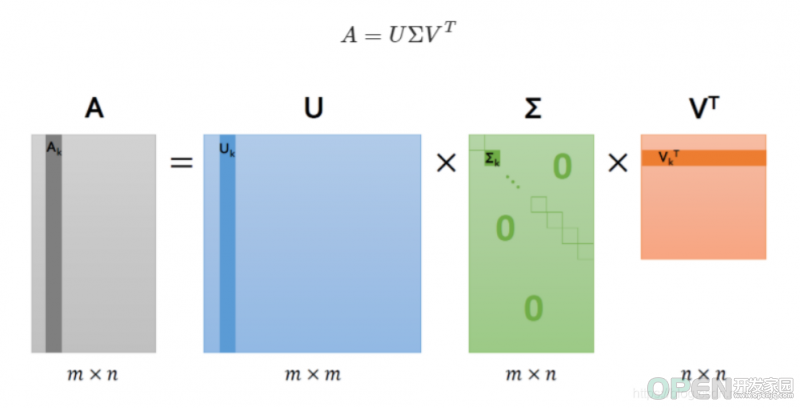

每行对应一个文档,每列对应一个概念 定义了文档空间和概念空间之间的映射 具有奇异值 每个????中的对角元素对应于一个概念 这些奇异值的大小对应于该概念的重要性 每行对应一个术语,每列对应一个概念 它定义了term空间(每个点是一个n维向量,对每个项都有权重)和概念空间(每个点是一个k维向量,对每个概念都有权重)之间的映射。每个位置上的值可以解释为该术语与该概念的相关性

import org.apache.hadoop.conf.Configuration

import org.apache.hadoop.io.{LongWritable,Text}

import org.apache.spark.ml.feature.{CountVectorizer,IDF}

import org.apache.spark.sql.functions._

import org.apache.spark.sql.{DataFrame,Dataset,SparkSession}

import scala.collection.JavaConverters._

import scala.collection.mutable.ArrayBuffer

import java.util.Properties

//import java.io.ByteArrayInputStream;

import edu.umd.cloud9.collection.XMLInputFormat

import edu.stanford.nlp.ling.CoreAnnotations.{LemmaAnnotation,SentencesAnnotation,TokensAnnotation}

import edu.stanford.nlp.pipeline.{Annotation,StanfordCoreNLP}

//import info.bliki.wiki.dump ._

//import org.xml.sax.SAXException

//import spark.implicits._

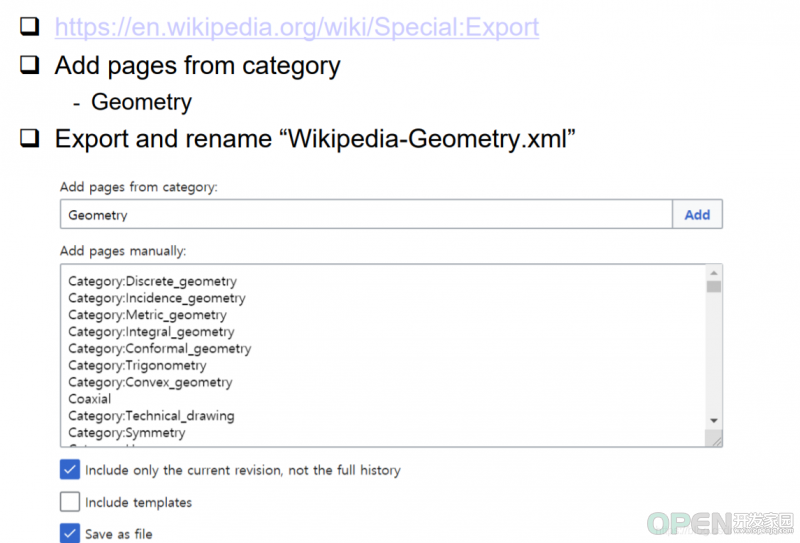

val path = "Data/Wiki/Wikipedia-Geometry.xml"

@transient val conf = new Configuration()

conf.set(XMLInputFormat.START_TAG_KEY,"<page>")

conf.set(XMLInputFormat.END_TAG_KEY,"</page>");

val kvs = spark.sparkContext.newAPIHadoopFile(path,classOf[XMLInputFormat],classOf[LongWritable],classOf[Text],conf)

val rawXmls = kvs.map(_._2.toString).toDS()

import info.bliki.wiki.dump._

import org.xml.sax.SAXException

import spark.implicits._

import java.io.ByteArrayInputStream;

case class Page(var page: WikiArticle = new WikiArticle) {}

class ArticleFilter(val Page: Page) extends IArticleFilter {

@throws(classOf[SAXException])

def process(page: WikiArticle,siteinfo: Siteinfo){

Page.page = page

}

}

def WikiXmlToPlainText (pageXml: String): Option[(String,String)]= {

val Page = new Page

try {

val parser = new WikiXMLParser(new ByteArrayInputStream(pageXml.getBytes),new ArticleFilter(Page))

parser.parse()

} catch {

case e: Exception =>

}

val page = Page.page

if (page.getText != null && page.getTitle != null

&& page.getId != null && page.getRevisionId != null

&& page.getTimeStamp != null && !page.isTemplate) {

Some((page.getTitle,page.getText ))

}else {

None

}

}

val docTexts = rawXmls.filter(_ != null ).flatMap(WikiXmlToPlainText)

def createNLPPipeline():StanfordCoreNLP = {

val props = new Properties()

props.put("annotators","tokenize,ssplit,pos,lemma")

new StanfordCoreNLP(props)

}

def isOnlyLetters(str: String): Boolean = {

str.forall(c => Character.isLetter(c))

}

def plainTextToLemmas(text:String,stopWords:Set[String],pipeline:StanfordCoreNLP): Seq[String] = {

val doc = new Annotation(text)

pipeline.annotate(doc)

val lemmas = new ArrayBuffer[String]()

val sentences = doc.get(classOf[SentencesAnnotation])

for (sentence <- sentences.asScala;

token <- sentence.get(classOf[TokensAnnotation]).asScala){

val lemma = token.get(classOf[LemmaAnnotation])

if ( lemma.length > 2 && !stopWords.contains(lemma) && isOnlyLetters(lemma)){

lemmas += lemma.toLowerCase

}

}

lemmas

}

val stopWords = scala.io.Source.fromFile("stopwords.txt" ).getLines().toSet

val bStopWords = spark.sparkContext.broadcast(stopWords)

val terms: Dataset[(String, Seq[String])]=

docTexts.mapPartitions { iter =>

val pipeline = createNLPPipeline()

iter.map { case(title, contents) =>

(title,plainTextToLemmas(contents,bStopWords.value,pipeline))

}

}

val termsDF=terms.toDF("title","terms")

val filtered = termsDF.where(size($"terms")>1)

filtered.show

val numTerms=20000

val countVectorizer=new CountVectorizer().

setInputCol("terms").

setOutputCol("termFreqs").

setVocabSize(numTerms)

val vocabModel=countVectorizer.fit(filtered)

val docTermFreqs=vocabModel.transform(filtered)

docTermFreqs.cache()

val idf=new IDF().

setInputCol("termFreqs").

setOutputCol("tfidfVec")

val idfModel = idf.fit(docTermFreqs)

val docTermMatrix=idfModel.transform(docTermFreqs).select("title","tfidfVec")

val termIds:Array[String]=vocabModel.vocabulary

val docIds=docTermFreqs.rdd.map(_.getString(0)).zipWithUniqueId().map(_.swap).collect().toMap

import org.apache.spark.mllib.linalg.{Vectors,Vector => MLLibVector}

import org.apache.spark.ml.linalg.{Vector =>MLVector}

val vecRdd = docTermMatrix.select("tfidfVec").rdd.map { row =>

Vectors.fromML( row .getAs[MLVector]("tfidfVec"))

}

import org.apache.spark.mllib.linalg.distributed.RowMatrix

vecRdd.cache()

val mat = new RowMatrix(vecRdd)

val k = 500

val svd = mat.computeSVD(k,computeU=true)

import org.apache.spark.mllib.linalg.{Matrix,SingularValueDecomposition}

import org.apache.spark.mllib.linalg.distributed.RowMatrix

def topTermsInTopConcepts(

svd: SingularValueDecomposition[RowMatrix,Matrix],

numConcepts: Int ,

numTerms: Int , termIds: Array[String])

: Seq[Seq[(String,Double)]] = {

val v = svd.V

val topTerms = new ArrayBuffer[Seq[(String,Double)]]()

val arr = v.toArray

for (i <- 0 until numConcepts) {

val offs = i * v.numRows

val termWeights = arr.slice(offs,offs + v.numRows).zipWithIndex

val sorted = termWeights.sortBy(-_._1)

topTerms += sorted.take(numTerms ).map {

case (score,id) =>( termIds(id), score)

}

}

topTerms

}

def topDocsInTopConcepts(

svd:SingularValueDecomposition[RowMatrix,Matrix],

numConcepts: Int , numDocs: Int,docIds: Map[Long,String])

: Seq[Seq[(String,Double)]] = {

val u = svd.U

val topDocs = new ArrayBuffer[Seq[(String,Double)]]()

for ( i <- 0 until numConcepts) {

val docWeights = u.rows.map(_.toArray(i)).zipWithUniqueId()

topDocs += docWeights.top(numDocs).map {

case (score,id) => (docIds(id),score)

}

}

topDocs

}

val topConceptTerms = topTermsInTopConcepts(svd ,6,10,termIds)

val topConceptDocs = topDocsInTopConcepts(svd ,6, 10,docIds)

for ((terms,docs) <- topConceptTerms.zip(topConceptDocs)){

println("Concept terms:" + terms.map(_._1).mkString(","))

println("Concept docs:" + docs.map(_._1).mkString("," ))

println()

}

![]() 网络安全

发布于:2021-07-13 18:33

|

阅读数:666

|

评论:0

网络安全

发布于:2021-07-13 18:33

|

阅读数:666

|

评论:0

QQ好友和群

QQ好友和群 QQ空间

QQ空间